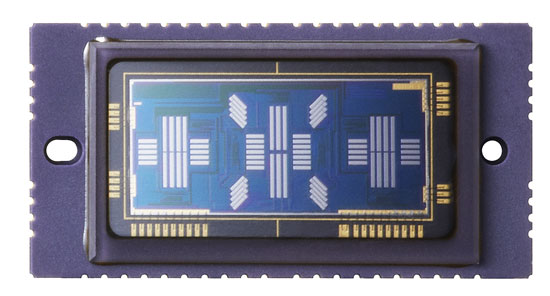

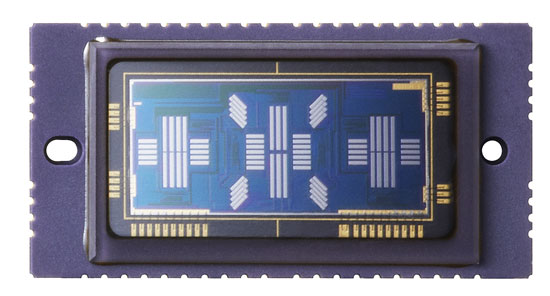

L'autofocus à détection de phase fonctionne en mesurant le déplacement horizontal entre les motifs de luminosité projetés sur le capteur AF. Pour mesurer le déplacement, des paires de réseaux unidimensionnels de pixels monochromes sont utilisés. Voici à quoi ressemble le capteur AF du Canon 5D mkIII:

Vous pouvez voir de nombreuses lignes de pixels différentes utilisées par différents collimateurs autofocus sélectionnables par l'utilisateur. En principe, vous pouvez utiliser des lignes de pixels sur le capteur d'image principal pour effectuer exactement le même travail.

Cette approche présente quelques avantages:

Vous ne rencontrez aucun problème si le capteur d'image principal et le capteur AF sont désalignés, car ils sont identiques.

Vous évitez la complexité des miroirs secondaires et le coût de la puce AF elle-même.

Il y a des inconvénients à utiliser le capteur principal.

Dans un commentaire sous la réponse liée, il est noté que le capteur AF nécessite un objectif pour focaliser les faisceaux de lumière sur l'emplacement approprié du capteur car il est plus petit que le capteur principal (l'italique est ma propre hypothèse)

Votre hypothèse n'est pas tout à fait juste. Cela n'a rien à voir avec un capteur AF plus petit, les "objectifs" AF sont en fait un objectif avec un profil en forme de "B" ondulé. Cet objectif concentre la lumière provenant de chaque côté de l'objectif sur différentes parties du capteur AF.

Vous auriez toujours besoin d'une sorte d'objectif pour faire ce travail lors de l'utilisation du capteur d'image principal, et il devrait s'éloigner lors de la prise de vue avec le miroir reflex, nécessitant une disposition mécanique compliquée dans l'appareil photo. C'est le principal inconvénient de cette approche, bien qu'il existe d'autres obstacles:

Les pixels du capteur d'image se trouvent derrière des matrices de filtres couleur qui réduisent la quantité de lumière qui les atteint jusqu'à deux tiers. Cela pourrait potentiellement réduire les performances par faible luminosité, mais cela vous permettrait d'effectuer la correspondance de mesure de phase en couleur pour moins de faux résultats (vous êtes moins susceptible de confondre un détail du premier plan avec un détail de l'arrière-plan par exemple La couleur peut également être utilisée pour faciliter le suivi).

La taille, l'espacement et la sensibilité des pixels seront différents entre les deux capteurs, donc faire les deux avec un capteur signifie que des compromis doivent être faits.

Le capteur principal devrait être allumé pendant des périodes beaucoup plus longues, ce qui entraînerait une plus grande consommation d'énergie des batteries. Comme le souligne Stan, l'obturateur devrait également être ouvert pendant la mise au point automatique, donc le fermer avant de réaliser l'exposition entraînerait un retard.

Enfin, la détection de phase AF est antérieure aux capteurs d'images numériques, de sorte que toute la technologie et les outils pour effectuer la AF à l'aide d'un capteur séparé existent déjà et sont bien développés.

Cependant les fabricants ont mis au point une méthode légèrement différente pour la phase AF à détection qui fait utiliser le capteur principal. Il a été développé pour les appareils photo sans miroir qui n'ont pas l'option d'un capteur AF dédié et qui ont traditionnellement utilisé la méthode de détection de contraste plus lente utilisant le capteur principal.

Au lieu d'une paire de lentilles AF sur le trajet de la lumière pour diriger la lumière de chaque côté de la lentille sur différentes parties du capteur AF, des paires de microlentilles régulières avec des moitiés alternées noircies peuvent être utilisées pour obtenir un effet similaire (pixels avec la gauche la moitié occultée recevra principalement la lumière du côté droit de l'objectif et vice versa).

Cela permet une approche AF hybride utilisant une combinaison de phase (pour se rapprocher de la bonne mise au point) et de détection de contraste (pour affiner le résultat).