Les défis de golf neuronaux précédents ( ceci et cela ) m'ont inspiré à poser un nouveau défi:

Le défi

Trouver le plus petit réseau neuronal à action directe tel que, étant donné tout vecteur d'entrée à 4 dimensions avec des entrées entières dans , les sorties du réseau avec une erreur de coordonnées strictement inférieure à .

Admissibilité

Pour ce défi, un réseau neuronal à action directe est défini comme une composition de couches . Une couche est une fonction qui est spécifiée par une matrice de poids , un vecteur de biais et une fonction d'activation qui est appliquée en coordonnée- sage:

Étant donné que les fonctions d'activation peuvent être réglées pour une tâche donnée, nous devons restreindre la classe des fonctions d'activation pour garder ce défi intéressant. Les fonctions d'activation suivantes sont autorisées:

Identité.

ReLU.

Softplus.

Tangente hyperbolique.

Sigmoïde.

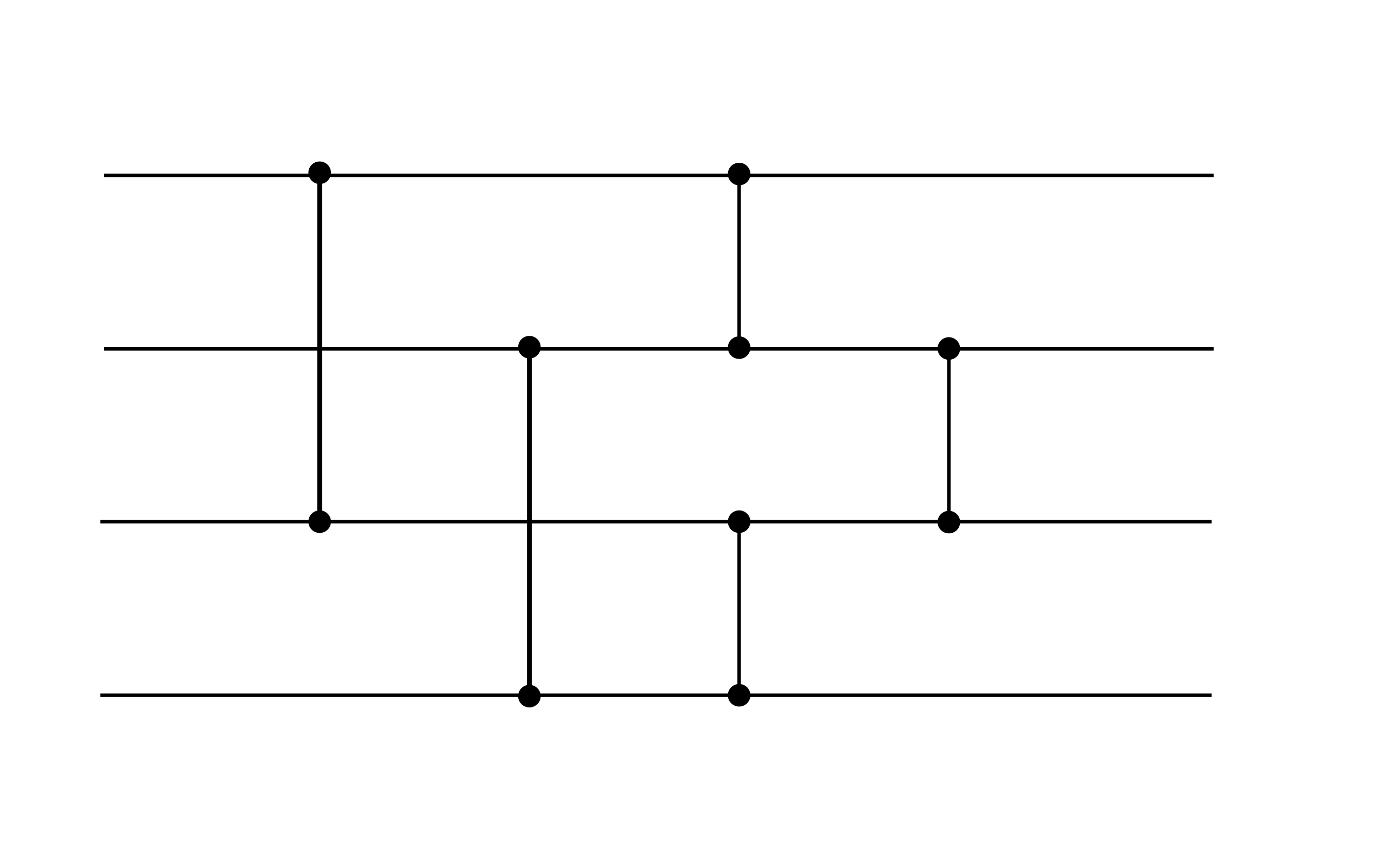

Dans l'ensemble, un réseau neuronal admissible prend la forme pour certains , où chaque couche est spécifiée par les poids , les biais et une fonction d'activation de la liste ci-dessus. Par exemple, le réseau neuronal suivant est admissible (bien qu'il ne satisfasse pas l'objectif de performance de ce défi, il peut être un gadget utile):

Cet exemple présente deux couches. Les deux couches n'ont aucun biais. La première couche utilise l'activation ReLU, tandis que la seconde utilise l'activation d'identité.

Notation

Votre score est le nombre total de poids et de biais différents de zéro .

(Par exemple, l'exemple ci-dessus a un score de 16 car les vecteurs de biais sont nuls.)